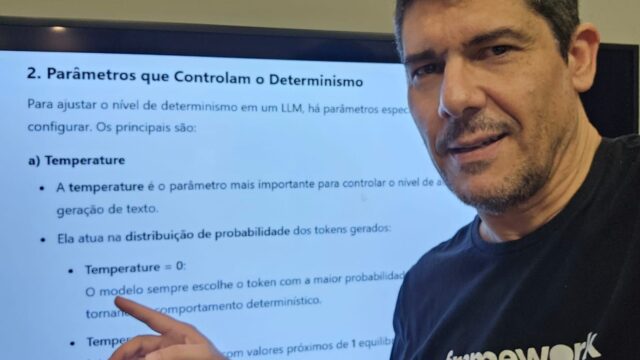

LLMs são Determinísticas ou Não Determinísticas

Neste ensaio, gostaria de 𝗰𝗼𝗺𝗽𝗮𝗿𝘁𝗶𝗹𝗵𝗮𝗿 𝘂𝗺𝗮 𝗱ú𝘃𝗶𝗱𝗮 que me acompanha há algum tempo sobre as respostas geradas pelos 𝗟𝗟𝗠𝘀. Se eu fizer a mesma pergunta ao ChatGPT diversas vezes, em grande parte dos casos, ele me fornecerá respostas escritas de forma diferente. Ou seja, embora o contexto permaneça o mesmo, o texto retornado será reescrito com outras palavras. Algumas respostas podem ser muito similares entre si, mas em certos casos, as variações são tão grandes que acabam gerando confusão. Diante disso, surge a questão: os LLMs são 𝗱𝗲𝘁𝗲𝗿𝗺𝗶𝗻í𝘀𝘁𝗶𝗰𝗼𝘀 ou 𝗻ã𝗼 𝗱𝗲𝘁𝗲𝗿𝗺𝗶𝗻í𝘀𝘁𝗶𝗰𝗼𝘀?

𝗗𝗲𝘁𝗲𝗿𝗺𝗶𝗻𝗶𝘀𝗺𝗼 implica que, dada a mesma entrada e condições idênticas, a saída será sempre a mesma. No caso dos LLMs, no entanto, eles são 𝗻ã𝗼 𝗱𝗲𝘁𝗲𝗿𝗺𝗶𝗻í𝘀𝘁𝗶𝗰𝗼𝘀 𝗽𝗼𝗿 𝗽𝗮𝗱𝗿ã𝗼. Isso ocorre porque utilizam amostragem probabilística para escolher a próxima palavra ou token, com base em uma distribuição de probabilidades calculada a partir do contexto fornecido.

Os LLMs, como os modelos da família GPT e alternativas como o LLaMA, desempenham um papel fundamental na geração de textos, diálogos e em diversas aplicações baseadas em inteligência artificial. Uma característica essencial a ser compreendida é o nível de determinismo desses modelos, ou seja, se uma mesma entrada resultará sempre na mesma saída ou se haverá variações. Para isso, é importante conhecer os fatores que influenciam a geração do texto nas respostas, como a amostragem probabilística e os parâmetros configurados durante o processo de inferência.

Quando os LLMs são treinados e disponibilizados, algumas propriedades são configuradas para determinar o quão determinístico ou criativo será o comportamento do modelo. Uma dessas propriedades é a 𝘁𝗲𝗺𝗽𝗲𝗿𝗮𝘁𝘂𝗿𝗲. No caso do GPT, essa propriedade varia de 0 a 2. Quanto mais próxima de 0, mais determinísticas serão as respostas, ou seja, o modelo tende a escolher a palavra mais provável em cada etapa. Por outro lado, valores próximos de 2 aumentam a liberdade criativa, permitindo que o modelo explore opções menos prováveis e produza respostas mais variadas e criativas. Para o GPT, estima-se que a 𝘁𝗲𝗺𝗽𝗲𝗿𝗮𝘁𝘂𝗿𝗲 seja configurada, por padrão, em 0.7, representando um equilíbrio entre coerência e criatividade na geração do texto.

Embora a temperature seja uma propriedade dos LLMs, no ChatGPT utilizado diretamente pela interface da OpenAI, não é possível ajustar esse parâmetro manualmente. Para modificar o valor da temperature, é necessário acessar o modelo por meio da API do ChatGPT, onde o ajuste pode ser feito de forma personalizada. Portanto, sempre que você interage com o ChatGPT através da interface padrão, as respostas geradas estarão sujeitas ao valor padrão da temperature definido pelo próprio modelo.

Além da temperature, ainda existem outras propriedades que influenciam no determinismo dos LLMs como Top-p e Random Seed, mas deixarei para falar delas em outro ensaio.