T𝗲𝗻𝘀𝗼𝗿𝗲𝘀 em AI

No ensaio de hoje, exploro um conceito fundamental em AI: os 𝘁𝗲𝗻𝘀𝗼𝗿𝗲𝘀. Para quem está começando neste campo, conhecido como 𝗔𝗜 𝗘𝗻𝗴𝗶𝗻𝗲𝗲𝗿𝗶𝗻𝗴, o termo “𝘁𝗲𝗻𝘀𝗼𝗿” é recorrente e aplicado em praticamente qualquer algoritmo de treinamento de máquinas. Embora o conceito seja relativamente simples, sua aplicação é extremamente valiosa.

Em inteligência artificial, tensores são 𝗲𝘀𝘁𝗿𝘂𝘁𝘂𝗿𝗮𝘀 𝗱𝗲 𝗱𝗮𝗱𝗼𝘀 𝗺𝘂𝗹𝘁𝗶𝗱𝗶𝗺𝗲𝗻𝘀𝗶𝗼𝗻𝗮𝗶𝘀 usadas para organizar e manipular grandes volumes de dados (como imagens, textos ou sons) de maneira eficiente. Eles possibilitam operações complexas em redes neurais e são fundamentais para o processamento paralelo em 𝗚𝗣𝗨𝘀, o que facilita o treinamento e a execução dos modelos de aprendizado de máquina.

O uso exato dos tensores pode variar conforme a abordagem estatística escolhida, mas, de modo geral, eles são essenciais para o funcionamento dos algoritmos de AI. Em resumo, tensores são vetores multidimensionais que aproveitam o poder de processamento das GPUs.

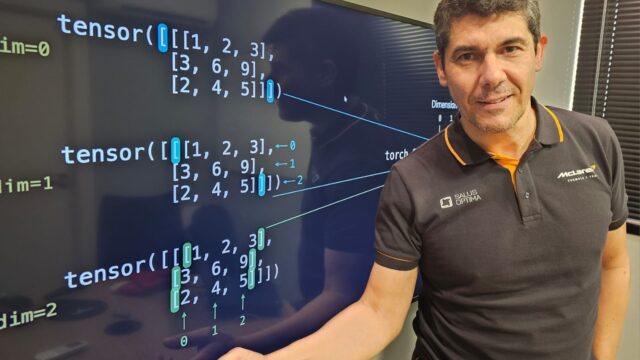

No 𝗣𝘆𝗧𝗼𝗿𝗰𝗵, por exemplo, os tensores são a base para construir e treinar modelos de inteligência artificial. Eles funcionam como matrizes multidimensionais, permitindo o processamento rápido de grandes volumes de dados. Para criar um tensor, basta importar a biblioteca com 𝗶𝗺𝗽𝗼𝗿𝘁 𝘁𝗼𝗿𝗰𝗵 e usar comandos como 𝘁𝗼𝗿𝗰𝗵.𝘁𝗲𝗻𝘀𝗼𝗿(), que transforma listas em tensores, ou 𝘁𝗼𝗿𝗰𝗵.𝘇𝗲𝗿𝗼𝘀(), que cria tensores preenchidos com zeros. Esses tensores podem ser manipulados, somados, multiplicados e até processados diretamente na GPU, acelerando cálculos complexos e permitindo que o 𝗗𝗲𝗲𝗽 𝗟𝗲𝗮𝗿𝗻𝗶𝗻𝗴 seja explorado de forma prática e eficiente.

Como mencionado, tensores são processados em GPUs de maneira altamente paralelizada, aproveitando a capacidade das GPUs de executar milhares de operações simultaneamente. Cada elemento do tensor é tratado como uma unidade de dados independente, permitindo que a GPU execute cálculos em todas as dimensões ao mesmo tempo—essencial para redes neurais que precisam processar grandes volumes de dados rapidamente. As GPUs dividem esses cálculos em “threads” que rodam paralelamente em diversos “cores” da placa, otimizando operações como multiplicação e soma de matrizes. Essa capacidade de processamento paralelo torna o treinamento e a inferência de modelos de deep learning muito mais rápidos em GPUs, quando comparado a CPUs, onde as operações seriam realizadas de forma sequencial.

Dessa forma, para quem estiver começando a programar e treinar suas próprias máquinas, é indispensável conhecer como os tensores funcionam e em que momento eles devem ser aplicados.